はじめに¶

生体内 (in vivo) の大脳皮質のニューロンは典型的に, (1) 発火の時系列パターンが不規則であり (発火時間間隔 (interspike interval; ISI) の分布が指数分布に近い), (2) ニューロン同士はほぼ無相関に発火するという特徴を持つ. 一方, 生体外 (in vitro) の電気生理記録から, 大脳皮質のニューロンは決定論的にふるまうことが知られている. それでも, 大脳皮質のニューロンは相互に結合しているのだから, 入力として他のニューロンの発火の不規則なパターンを受けることにより不規則な発火パターンを出力するというメカニズムが考えられる. しかし, この素朴に考えれば「自然な」メカニズムは, 簡単な考察から破綻することが分かる.

個のニューロンが相互に結合した系を考える.

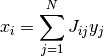

それぞれのニューロンは平均して

個のニューロンが相互に結合した系を考える.

それぞれのニューロンは平均して  個のニューロンから入力を受けているとし, 行列

個のニューロンから入力を受けているとし, 行列  を用いて,

を用いて,

番目のニューロンが

番目のニューロンが  番目のニューロンからの入力を受けているなら

番目のニューロンからの入力を受けているなら  そうでなければ

そうでなければ  として結合を表現する. ここで結合力を

として結合を表現する. ここで結合力を  とスケールした理由は以下で明らかになる. 以下の議論は興奮性の集団 (

とスケールした理由は以下で明らかになる. 以下の議論は興奮性の集団 ( ) でも抑制性の集団 (

) でも抑制性の集団 ( ) でも成り立つ.

ニューロンの数やその結合の数は非常に大きいので,

) でも成り立つ.

ニューロンの数やその結合の数は非常に大きいので,

の極限で現れる普遍的な性質を調べる. ニューロン

の極限で現れる普遍的な性質を調べる. ニューロン

への入力を

への入力を  , その出力を

, その出力を  と書く.

入力

と書く.

入力  がどのように出力

がどのように出力  に変換されるかは指定しないが, 何らかの決定論的な仕組みに依る, つまり出力の不規則性は入力の不規則性のみに依るという仮定をする.

簡単のために, すべてのニューロンの出力

に変換されるかは指定しないが, 何らかの決定論的な仕組みに依る, つまり出力の不規則性は入力の不規則性のみに依るという仮定をする.

簡単のために, すべてのニューロンの出力  は独立で, 同じ平均

は独立で, 同じ平均  (「ネットワークの平均発火率」のようなもの) を持つとする. さらに, 入力

(「ネットワークの平均発火率」のようなもの) を持つとする. さらに, 入力  が線形和

が線形和

で表されるとする.

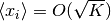

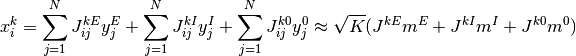

右辺はたくさんの  の和なのだから, 大数の法則 (law of large numbers)

により「その平均 (

の和なのだから, 大数の法則 (law of large numbers)

により「その平均 ( )

×

)

×  が非ゼロの時の値 (

が非ゼロの時の値 ( )

×

)

×  が非ゼロの個数 (

が非ゼロの個数 ( )」で近似出来るはずである.

つまり,

)」で近似出来るはずである.

つまり,  となる. 結合力が

となる. 結合力が  という選択は

という選択は  が

が  で発散しないために必要だったのである.

しかし, この場合, 中心極限定理 (central limit theorem) により

で発散しないために必要だったのである.

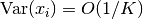

しかし, この場合, 中心極限定理 (central limit theorem) により  の分散は

の分散は  とスケールすることが期待される.

つまり,

とスケールすることが期待される.

つまり,  の不規則性は

の不規則性は  の極限で消えてしまう. よって, 出力

の極限で消えてしまう. よって, 出力  の不規則性は入力

の不規則性は入力  の不規則性にのみに依るという仮定から, 出力

の不規則性にのみに依るという仮定から, 出力  の不規則性も消えてしまう. しかし, この結論は出力

の不規則性も消えてしまう. しかし, この結論は出力  に不規則性があるという仮定のもとで導いたのだから, 矛盾している. つまり,

このモデルは間違っている.

に不規則性があるという仮定のもとで導いたのだから, 矛盾している. つまり,

このモデルは間違っている.

この現象を避けるには, 結合力を  から

から

に変更すれば良い.

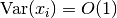

この場合, 同じく 中心極限定理 (central limit theorem) により

に変更すれば良い.

この場合, 同じく 中心極限定理 (central limit theorem) により  となる. つまり,

となる. つまり,  の極限でも不規則性が消えない.

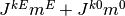

ところが, 平均は

の極限でも不規則性が消えない.

ところが, 平均は  となり,

となり,

の極限で発散してしまう. 生物学的なモデルでは変数は常に一定の範囲内に収まっているべきであり, 平均が発散するモデルは使えない.

の極限で発散してしまう. 生物学的なモデルでは変数は常に一定の範囲内に収まっているべきであり, 平均が発散するモデルは使えない.

しかし, この困難は相互に結合した興奮性と抑制性の集団と, それらの集団への外部からの興奮性入力 [1] を考えると解決出来る.

興奮性の集団を上付添字  ,

抑制性の集団を上付添字

,

抑制性の集団を上付添字  ,

外部の (興奮性) 集団を上付添字

,

外部の (興奮性) 集団を上付添字  で表し, 例えば

で表し, 例えば  番目の興奮性ニューロンへの入力は

番目の興奮性ニューロンへの入力は  で,

抑制性ニューロンから興奮性ニューロンへの結合の強さは

で,

抑制性ニューロンから興奮性ニューロンへの結合の強さは

とする.

集団

とする.

集団  は興奮性なので

は興奮性なので  (

( ),

集団

),

集団  は抑制性なので

は抑制性なので  (

( ) であることに注意.

集団

) であることに注意.

集団  (

( ) への入力は

) への入力は

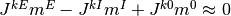

となる. ここで  は正で

は正で

は負である. よって, これらの値がうまく釣り合えば, つまり,

は負である. よって, これらの値がうまく釣り合えば, つまり,

が成り立てば, 入力

が成り立てば, 入力  は発散しない.

本稿ではこの条件の成り立つネットワークを

興奮・抑制均衡ネットワーク と呼び, その特性を解析する.

素朴に考えるとそのためには各結合力

は発散しない.

本稿ではこの条件の成り立つネットワークを

興奮・抑制均衡ネットワーク と呼び, その特性を解析する.

素朴に考えるとそのためには各結合力  (

( ) を注意深く選ぶ (fine tuning する)

必要があり, 恣意的なモデルに見える. よって,

興奮・抑制均衡ネットワークの重要なアイディアは, この条件が

自動的に [2] 達成されることにある.

もちろんそのためには結合力

) を注意深く選ぶ (fine tuning する)

必要があり, 恣意的なモデルに見える. よって,

興奮・抑制均衡ネットワークの重要なアイディアは, この条件が

自動的に [2] 達成されることにある.

もちろんそのためには結合力  はある条件を満たす必要があるが, その条件は大変ゆるい.

はある条件を満たす必要があるが, その条件は大変ゆるい.

| [1] | ここでの議論だけでは外部の集団を考える必然性は自明では無い. しかし, 興奮・抑制均衡ネットワークは外部の集団なしでは成り立たないことを後に述べる. |

| [2] | 力学系の言葉で言えば, この条件が達成された状態が漸近安定. |

まず, 興奮・抑制均衡ネットワーク でネットワークの詳細には依らない特性を導く. そして, 二状態ニューロンのネットワーク で上記のアイディアが統計力学的な厳密な系で成立することを示す. 興奮・抑制均衡ネットワーク と 二状態ニューロンのネットワーク の大部分の議論はゆるやかにしか繋がっていないので, どちらから読み始めても良い. 二状態ニューロンのネットワーク で 興奮・抑制均衡ネットワーク の議論が必要になるのは, 安定性解析 の部分だけである.

課題

文献を紹介する