はじめての興奮・抑制均衡¶

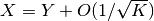

はじめに の簡単な議論から,  について興奮性と抑制性の入力が均衡した状態

について興奮性と抑制性の入力が均衡した状態

が成り立てば, ニューロンの活動の不規則性が説明出来ることが示唆された. ただし, 集団を表す添字を上付添字から下付添字に変更した. [1] [2]

| [1] | これ以降の議論では, 集団を表す添字は下付きで, ニューロンを表す添字を上付にする (例:  ). ). |

| [2] | 記号  の意味がきちんと定義されていないので条件の意味を把握するのは難しい. 実は, この節に現れる の意味がきちんと定義されていないので条件の意味を把握するのは難しい. 実は, この節に現れる  の形の式 (

の形の式 ( でも良い) を, すべて でも良い) を, すべて  に書き換えれば厳密な議論となる.

ただし,

に書き換えれば厳密な議論となる.

ただし,  は ランダウの記号 あるいは O-記法

(Big O notation) と呼ばれる漸近関係を表す記号のひとつである

(漸近解析 (Asymptotic analysis) を参照). は ランダウの記号 あるいは O-記法

(Big O notation) と呼ばれる漸近関係を表す記号のひとつである

(漸近解析 (Asymptotic analysis) を参照). |

外部入力の項を  と書き,

と書き,

なる行列・ベクトル表現を使えばこの式は

と書ける. 行列  が可逆であれば,

が可逆であれば,

(1)

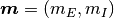

である. つまり,

ネットワークのパラメタ  と外部からの入力

と外部からの入力  が決まれば, このネットワークの「グローバルな状態」

が決まれば, このネットワークの「グローバルな状態」  はただひとつに決まる.

興奮性と抑制性の入力が常に均衡していればこの状態は時間変化しないはずであるから, これは

はただひとつに決まる.

興奮性と抑制性の入力が常に均衡していればこの状態は時間変化しないはずであるから, これは  のダイナミクスの固定点である. よって式 (1) を

均衡固定点 (balanced fixed point) と呼ぶ.

この式から

のダイナミクスの固定点である. よって式 (1) を

均衡固定点 (balanced fixed point) と呼ぶ.

この式から  なら

なら  なので, 外部入力がなければ興奮・抑制均衡ネットワークは活動出来ない (非ゼロの均衡固定点が存在しない) ことが分かる.

なので, 外部入力がなければ興奮・抑制均衡ネットワークは活動出来ない (非ゼロの均衡固定点が存在しない) ことが分かる.

一般論へ¶

上記の議論を正確におこなうには,  のダイナミクスが定義されていなくてはならない. しかも, それがひとつひとつは不規則なニューロンのダイナミクスから導出出来る必要がある.

この導出は 二状態ニューロンのネットワーク の 平均場方程式の導出 でおこなう.

しかし今は,

のダイナミクスが定義されていなくてはならない. しかも, それがひとつひとつは不規則なニューロンのダイナミクスから導出出来る必要がある.

この導出は 二状態ニューロンのネットワーク の 平均場方程式の導出 でおこなう.

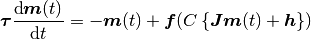

しかし今は,  のダイナミクスが

のダイナミクスが

(ただし,

,

,

,

,

,

,

である)

と書けることを仮定して議論を進めよう.

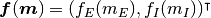

関数

である)

と書けることを仮定して議論を進めよう.

関数  や

や  は集団レベルでの,

入力と出力の関係を定義している. 例えばロジスティクス関数

は集団レベルでの,

入力と出力の関係を定義している. 例えばロジスティクス関数

を使うことを想像しても良い.

実は関数

を使うことを想像しても良い.

実は関数  はあるゆるい条件を満たせば何でも良いことがわかる.

はあるゆるい条件を満たせば何でも良いことがわかる.

「フィードバック強度」  は, はじめに の議論では

は, はじめに の議論では  のスケーリングをどう定義するかに依っていたが, この

のスケーリングをどう定義するかに依っていたが, この  の起原は興奮・抑制均衡ネットワークの特性を議論するためにほとんど効いてこない. そこで,

強フィードバック系 ではこの均衡固定点を別の視点から「導出」する.

の起原は興奮・抑制均衡ネットワークの特性を議論するためにほとんど効いてこない. そこで,

強フィードバック系 ではこの均衡固定点を別の視点から「導出」する.